OpenAI ha presentado recientemente una nueva versión de su modelo de lenguaje basado en Inteligencia Artificial, que ha sido utilizado para impulsar proyectos como ChatGPT y el nuevo motor de búsqueda de Microsoft, Bing.

La compañía ha presentado una nueva generación de su modelo de lenguaje, el cual ya estaba presente en el buscador de Microsoft. Este modelo acepta entradas de texto, como lo hacía la versión anterior, pero ahora también puede procesar imágenes. Cabe destacar que las respuestas siguen siendo solo en formato de texto.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) 14 de marzo de 2023

OpenAI ha anunciado su nueva versión del modelo de lenguaje GPT, llamado GPT-4, que a pesar de ser clasificado como “menos capaz que los humanos en muchos escenarios del mundo real”, cuenta con un desempeño a nivel humano en varios entornos académicos y profesionales, según la compañía. GPT-4 es más confiable, creativo y capaz de manejar instrucciones más matizadas que su predecesor, el GPT-3.5, superando significativamente a los modelos de lenguaje existentes y a la mayoría de los modelos de última generación. Cabe mencionar que, aunque la nueva versión admite imágenes como entrada, las respuestas generadas por la IA se mantienen exclusivamente en formato escrito.

¿Cómo funciona esta tecnología?

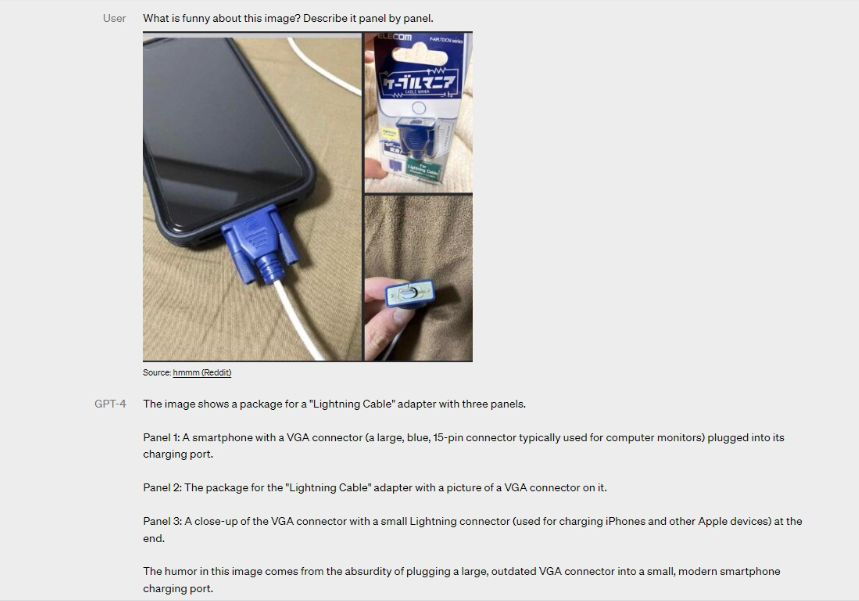

El modelo de lenguaje GPT-4, de acuerdo con la empresa, es capaz de aceptar tanto texto como imágenes como entrada al mismo tiempo, y también puede recibir instrucciones específicas del usuario, como la tarea a realizar o el idioma a utilizar. OpenAI ha afirmado que este modelo puede procesar documentos con texto, fotografías, diagramas e incluso capturas de pantalla, mostrando una capacidad similar a la de las entradas que solo contienen texto.

OpenAI ha indicado que, por el momento, las entradas de imágenes siguen siendo una función en fase experimental y no estarán disponibles al público en general.